SEO

フィクサー

0

フィクサー

0

robots.txtってなに??

Webサイトを担当している人やSEO対策をしている人には、robots.txtという言葉をよく目にしますよね。

私も、つい3か月前まではrobots.txtがどういう効果をもたらすのか一切知りませんでした。

実は、SEO対策をする上で知るべき重要な言葉になります。

なぜなら、Google(検索エンジン)のクローラー(ロボット)を円滑に効率よくWebサイトを回遊してもらえるための手法だからです。

今回は、robots.txtについて小学生でもわかるように解説します。

ぜひ、参考にしてください。

robots.txtとは、Google(検索エンジン)のクローラー(ロボット)がWebサイトにアクセスしたときに、アクセスを許可するページと許可しないページを指定することができる記述になります。

さらに砕けた言い方をするなら、、、

検索エンジンのロボットに「大事なページだけ見て」と命令することができます。

SEO対策をする上で、なぜ重要になってくるのか?その答えは、クロールが最適化されるからです。

クローラーの2つの特徴から、robots.txtを効果的に記述することでSEO対策になることがわかりますよね。

クローラーは、どのようにしてWebサイトにたどり着くのか?

2つのリンクを辿ってクローラーはWebサイトのページに訪問します。Webサイト内に内部リンクを多く設置しているページには、クローラーも多く訪問してくれるのです。

Webサイト(ドメイン)ごとにクローラーが回遊できるページ数に限りがあることを知っていましたか?

限られたページ数しか回遊できないなら、「大事なページだけ見て」と考えますよね?そんなときにrobots.txtを記述すれば、不必要なページの回遊を避けることができます。

robots.txtを記述して作成するのは、誰でも簡単に書くことができます。

記述する内容は主に4つあり、クロールしてほしいページとクロールしてほしくないページを指定するだけです。

| 指示をする単語 | 必須orどちらでも | 単語の意味 |

| User-agent | 必須 | 指示をするロボットを指定 |

| Disallow | どちらでも | アクセスを拒否するページを指定 |

| Allow | どちらでも | アクセスを許可するページを指定 |

| Sitemap | どちらでも | sitemap.xmlを入力する |

どんなページが不必要なの?と疑問に思っている人は、「ユーザーにとって無価値のコンテンツ」という判断基準で決めましょう。

User-agentとは、指示をするロボットを指定する役割になります。

★User-agentの例

クローラーの名前がわからない場合は、「クローラー 名称」と検索すると参考Webサイトがいくつか表示されます。

参考Webサイト:よく見かけるクローラの説明。当サイトによく巡回にくるクローラ Top 11 より。

Disallowとは、アクセスを拒否するページを指定する役割になります。

★Disallowの例

ユーザーが見て不必要なコンテンツ(サイトマップや404エラー)には、Disallowを記述しましょう。

Allowとは、アクセスを許可するページを指定する役割になります。

★Allowの例

基本的にDisallowでアクセス拒否してなければ、Allowを記述する必要はありません。

Sitemapとは、sitemap.xmlを格納するための場所です。記述すると、クローラーがアクセスしやすくなり、Webサイトのクローラビリティを向上することができます。

★Sitemapの例

ファイル名を必ずしも「Sitmap.xml」にする必要はありません。その他の名称でも機能します。

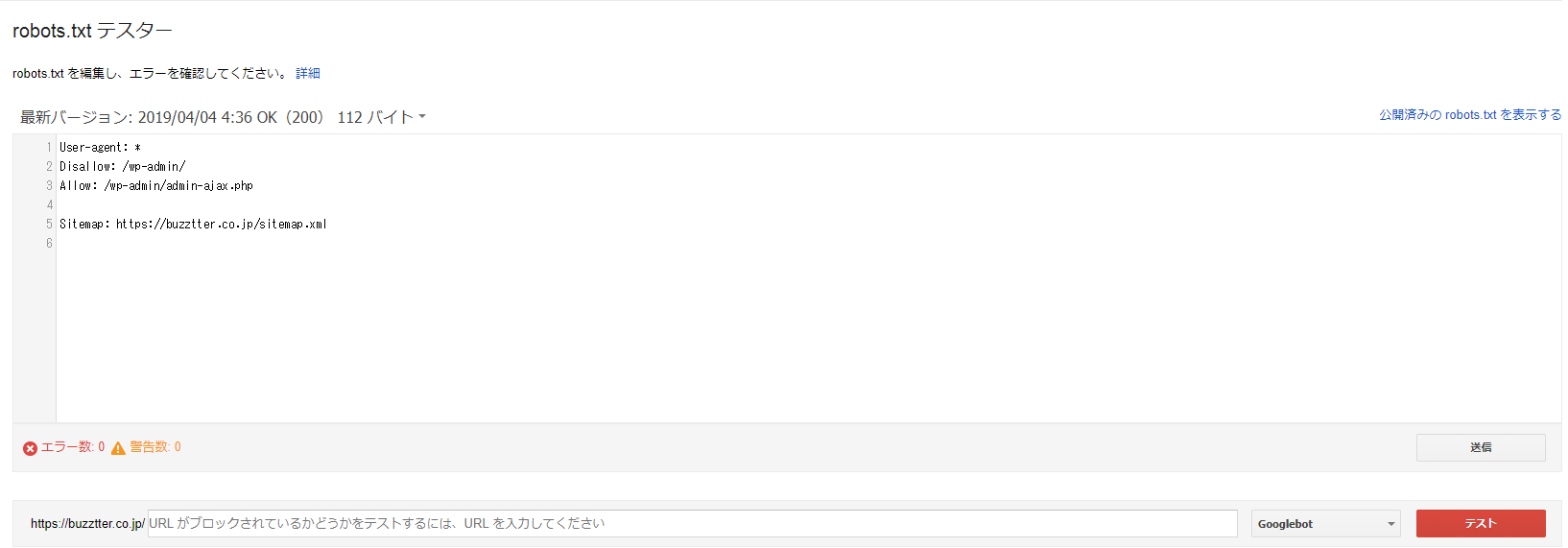

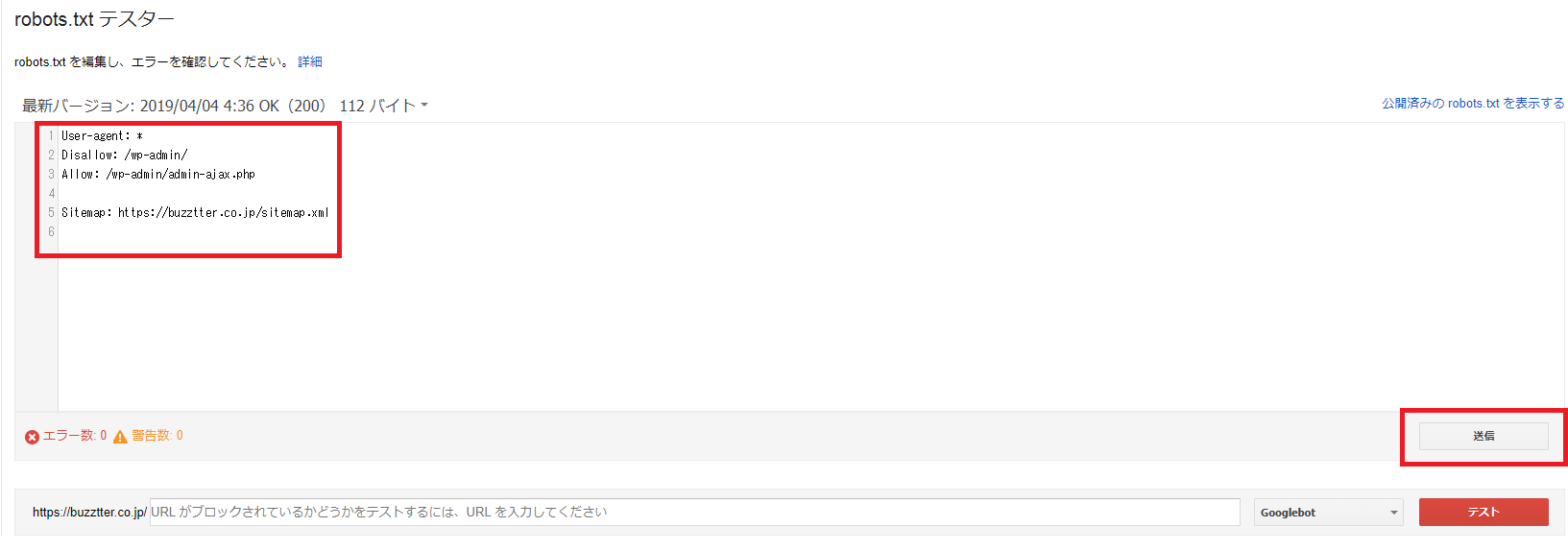

robots.txtの記述が完成したら、GoogleのSearch Consoleで動作を確認することができます。

robots.txtテスターの使い方をわかりやすく手順に沿って解説しましょう。

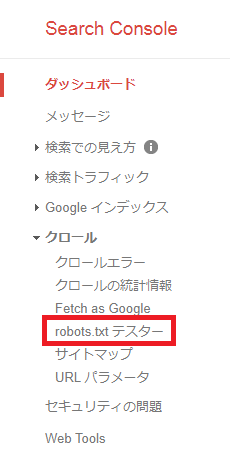

①Search Consoleにログイン

公式サイト:Google Search Console

②ダッシュボードのクロール→robots.txtテスターをクリック

③robots.txtを記述したら「送信」をクリック

あとは、robots.txtの記述が反映されるのを待つだけです。

robots.txtについて注意しておかなければならない点が5つあります。

Webサイトの担当者やSEO対策をしている人は、必ずrobots.txtの注意点を把握しておくべきです。

robots.txtを記述して必ずアクセスを拒否できるわけではありません。クローラーの中にはrobots.txtの記述を無視してアクセスを続けることもあります。

robots.txtを記述しても即座に反映されるわけではありません。反映されるまでに数分から数時間かかる場合があります。

robots.txtを記述してもユーザーはアクセスすることができます。あくまでもクローラーに命令をしているだけと認識してください。

ユーザーはrobots.txtの記述を見ることができます。見られたくない情報や非公開にしたい場合は、パスワードや認証設定をして対処してください。

重複コンテンツにrobots.txtを記述しないでください。重複コンテンツにrobots.txtを記述してしまうと、コンテンツの評価も0になってしまいます。

robots.txtはSEO対策をする上で、かかせない内部対策です。

基本的には、アクセスしてほしくないページ(アクセスする必要がないページ)がある場合に使用してください。

効果的にrobots.txtを使用することで、クローラビリティを劇的に向上することができます。

他よりも優れたWebサイトにするためにも絶対に覚えておきましょう。

会社案内・解説資料はこちら!

資料をダウンロードする ▷